Snapchat wusste es schon von Anfang an. Und in den vergangenen Monaten sind nun auch Google und Facebook dahintergekommen: Die Tastatur hat langsam aber sicher ausgedient. Letzte Woche bei Googles jährlicher Developer-Konferenz enthüllte das Unternehmen seine Vision, wie die Nutzer – mehr als eine Milliarde Menschen – in den kommenden Jahren stattdessen mit Technik interagieren sollen. Und das hat (größtenteils) nichts mehr damit zu tun, Text in ein Suchfeld einzugeben. Stattdessen tönte Google von seiner Spracherkennung und Google Lens – diese neue Computer-Vision-Technologie, die die Smartphone-Kamera in eine Suchmaschine verwandelt.

Dank AI wandelt sich die Art, wie wir Smartphones benutzen.

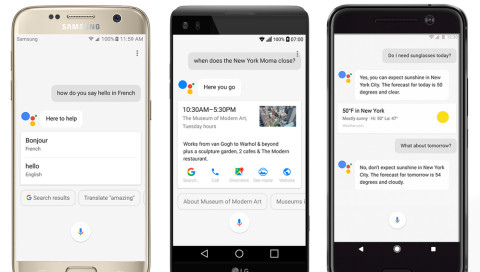

Technologie hat an dieser Stelle wieder einmal einen Wendepunkt erreicht. Jahrelang mussten sich Smartphones auf Tastaturen verlassen – ein Überbleibsel aus den Anfangstagen der Mobiltelefone. Dann kam Multitouch und die Menschen wischten, tippten und zoomten begeistert auf ihren Smartphone-Bildschirmen herum. Dank AI soll sich die Art, wie wir Smartphones benutzen, jetzt erneut wandeln. Ein Foto zu schießen, funktioniert vielleicht sogar besser als einen langen beschreibenden Text in die Suchmaske einzugeben. Beiläufig mit dem Google Assistant zu chatten, dem omnipräsenten virtuellen Helfer, liefert vielleicht schnellere Ergebnisse als erst die Chrome-App zu öffnen und von dort per Hand zu suchen. Am Ende läuft es darauf hinaus, so Google CEO Sundar Pichai, dass wir immer intuitiver, natürlicher und menschlicher mit unseren Computern interagieren und daher die Tastatur immer weniger benutzen.

Fragt man die Entwickler solcher neuen Technologien, sagen sie alle eins: Kameras sind die neuen Tastaturen. Das ist nicht nur ein griffiger Spruch, sondern wird inzwischen zum industrieweiten Mantra auf dem Weg zu einer viel visuelleren Form der Kommunikation mit Maschinen.

Snapchat ist ein gutes Beispiel dafür. Das Unternehmen hat von Anfang an darauf gesetzt, dass Menschen lieber Fotos statt Text austauschen. Die Idee erwies sich als so treffend, dass Facebook und Instagran ihre eigenen Versionen dieses Features entwickelten. „Die Kamera hat sich schon als alles durchdringende Form der Kommunikation erwiesen,“ sagt Roman Kalantari, Chef des Design Studios Fjord. „Aber was ist der nächste Schritt?“

Die Welt, in all ihrer Komplexität, kann mit einem Blick durch die Kameralinse erfasst werden.

Für Facebook und Snapchat kam er in Form verzerrender Spiegeleffekte und alberner Augmented-Reality-Filter, die mit Fotos in einer Weise umgehen, wie es Text nicht kann. Google entschied sich dagegen für eine etwas utilitaristischere Herangehensweise mit Lens. Die Kamera wurde selbst zum Eingabegerät. Richte die Kamera auf einen Baum und sie wird dir die genaue Art sagen. Schieß ein Foto des neuen Restaurants in der Nachbarschaft und die Öffnungszeiten und Speisekarte erscheinen. Die praktischste und gleichzeitig banalste Funktion: Richte die Linse auf Artikelnummer und Passwort deines Routers und Googles Bilderkennung wird die Information scannen und dich automatisch mit deinem Android-Telefon ins Netzwerk einloggen. Einfache Bedienbarkeit steht an oberster Stelle. Informationen zu finden, bedarf keiner Texteingabe in eine Suchzeile mehr. Die Welt, in all ihrer Komplexität, kann mit einem Blick durch die Kameralinse erfasst werden.

Google ist längst nicht die einzige Firma, die an diese Version der Zukunft glaubt. Amazons Fire Phone von 2014 hatte eine bilderbasierte Suchfunktion, bei der man seine Kamera auf eine Packung Cornflakes oder ein Buch halten konnte, um den Artikel von Amazon Prime liefern zu lassen.

Anfang des Jahres hat Pinterest seine eigene Beta-Version von Lens gestartet. Mit dem Tool können User Fotos von realen Objekten schießen und bekommen auf Pinterest Vorschläge ähnlicher Bilder. „Wir gelangen an einen Punkt, an dem das Benutzen der Kamera um Neues zu entdecken genauso schnell und einfach ist wie das Tippen” sagt Albert Pereta, der als Kreativ-Chef bei Pinterest die Entwicklung von Lens vorangetrieben hat.

Sprache ist eben maximal eine Annäherung an die Realität. Es ist oft besser zu zeigen, statt zu erzählen. Es ist einfacher diesen einen bestimmten Mahagoni-Stuhl aus der Mitte des vergangenen Jahrhunderts zu finden, wenn du dem Computer genau zeigen kannst wie er aussieht, anstatt es in einer Reihe von präzisen Keywords erklären zu müssen. „Mit einer Kamera erledigt du das, indem du ein Foto oder Video von dem Ding aufimmst,” erklärt Gerald Laput, der Mensch-Computer-Interaktion an der Carnegie Mellon studiert. „Auf der Tastatur musst du dir eine korrekte Beschreibung ausdenken und diese in Keywords übersetzen.”

Die Krux an der Sache ist allerdings, dass die Bilderkennung auch zuverlässig funktionieren muss. Man hat einen gewissen Handlungsspielraum, wenn man Worte in ein Feld tippt – kann korrigieren, löschen, überarbeiten. Eine Kamera entscheidet selbst, was sie auf dem Bild erkennt und muss selbstständig herausfinden, welches Ergebnis der Nutzer erwartet.

Die gute (und möglicherweise gruselige) Nachricht ist, dass Google mit jedem Foto, jeder Text- und jeder Spracheingabe mehr über einen lernt. Mit der Zeit werden die Ergebnisse also immer genauer. Mit seinem großen Erfahrungsschatz versucht Google, noch die letzten Ecken und Kanten an der Technologie zu beseitigen. Es dauert sicherlich noch eine Weile, bis die Tastatur ausstirbt. Aber mit jedem Schnappschuss kommen wir dieser Zukunft einen weiteren Schritt näher.