Das Fahrzeug, mit dem ich gleich verschmelzen soll, sieht aus wie eine Mischung aus Autoscooter und Mond-Rover. Einen Meter breit, zwei Meter lang und vier kleine Räder. Eine Stoßstange umrandet das Gefährt und oben thront ein Aufbau mit verschiedenen Sensoren. Diese Sensoren sollen meine Augen werden, sobald ich die VR-Brille aufsetze, die mir Raphael Reimann hinhält.

Reimann, 30, Geograf, Turnschuhe, hat mit seinen Kolleginnen vom Moovel Lab den Wagen gebaut, mit dem ich an diesem Junivormittag durch einen Hinterhof im Berliner Stadtteil Prenzlauer Berg fahren werde. So soll ich erfahren, wie es sich anfühlt, ein selbstfahrendes Auto zu sein.

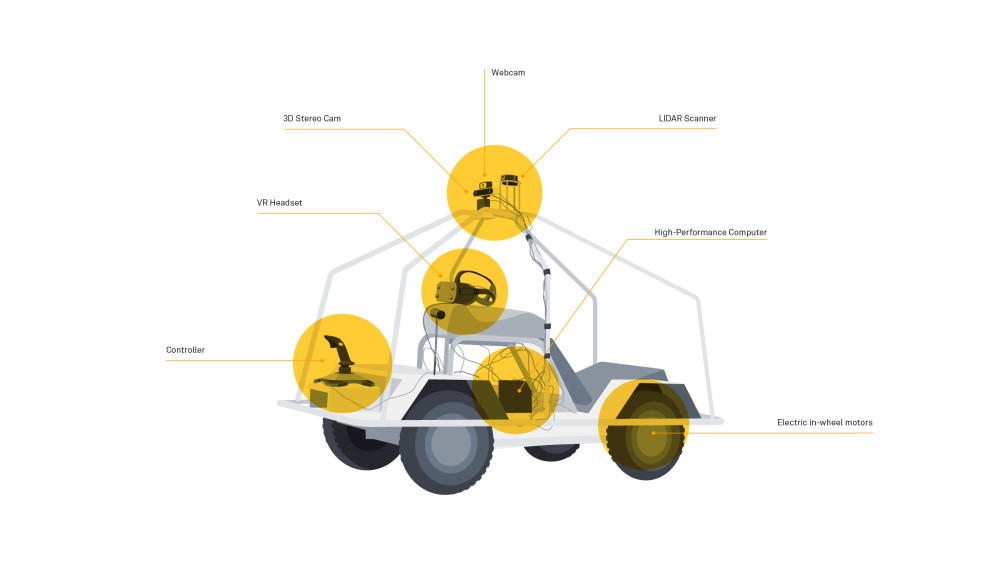

Ein Entwurf des Prototypen. Weil die Steuerung mit Joystick nicht funktionierte, haben ihn die Ingenieure vom Moovel Lab mit einem Lenkrad ersetzt.

Das Moovel Lab sitzt in Stuttgart, gehört zu einer Tochter des Autoherstellers Daimler und betreibt Grundlagenforschung zu allem, was mit Mobilität zu tun hat. Ausgangspunkt des Wagen-Projektes ist eine US-Studie: Jeder dritte Befragte gab an, dass er nie ein selbstfahrendes Auto kaufen würde. 60 Prozent sagten, dass sie fast nichts über autonomes Fahren wissen. Laut der Studie hängt das zusammen: Menschen lehnen Technologien ab, die ihnen fremd sind.

Um diese Fremdheit zu überwinden, hat Reimann mit seinem Team eine Kennenlern-Maschine gebaut. „Wir wollen die Akzeptanz für selbstfahrende Autos erhöhen“, sagt er. Was er nicht sagt: Wer selbstfahrende Autos akzeptiert, kauft vielleicht irgendwann eins, womöglich sogar von Daimler.

Ich muss auf mich aufpassen!

Dem Moovel Lab geht es weniger um rationales Verstehen der Technologie - nur Experten können im Detail nachvollziehen, wie Sensoren und Programme beim autonomen Auto zusammenspielen. Stattdessen sollen die Nutzer des Fahrzeugs die Technologie nachfühlen können und sie so kennenlernen. Immer wieder fallen Wörter wie „Emotionen“ und „Empathie“. Das fängt bei der Position des Testfahrers an. Im Wagen sitzt man nicht, sondern liegt auf dem Bauch. „Dahinter steht die Idee, dem Nutzer seine Verletzlichkeit vorzuführen“, sagt Reimann, „er soll denken: ‚Ich muss auf mich aufpassen‘“.

Mein Kopf ist einen guten Meter über dem Boden, genau auf Höhe der Scheinwerfer des SUVs, der mir gegenüber steht. Tatsächlich fühle ich mich ausgeliefert. Ich nehme die klobige Brille und schnalle sie mir um den Kopf. In meiner Liegeposition dürfte ich jetzt den Boden sehen, doch vor meinen Augen erstreckt sich der Hinterhof mit seinen weinberankten Ziegelsteinwänden, als ob ich aufgerichtet wäre.

Die Welt um mich erscheint nur deutlich dunkler und mit Streifen wie bei einem alten Schwarz-Weiß-Fernsehgerät. Was weiter als 10 Meter entfernt ist, wird komplett schwarz. Ansonsten liefert die 3D-Tiefenkamera eine getreue dreidimensionale Ansicht meiner Umgebung. Wenn ich den Kopf drehe, wandert mein Sichtfeld mit, weil ein Sensor meine Bewegungen erfasst.

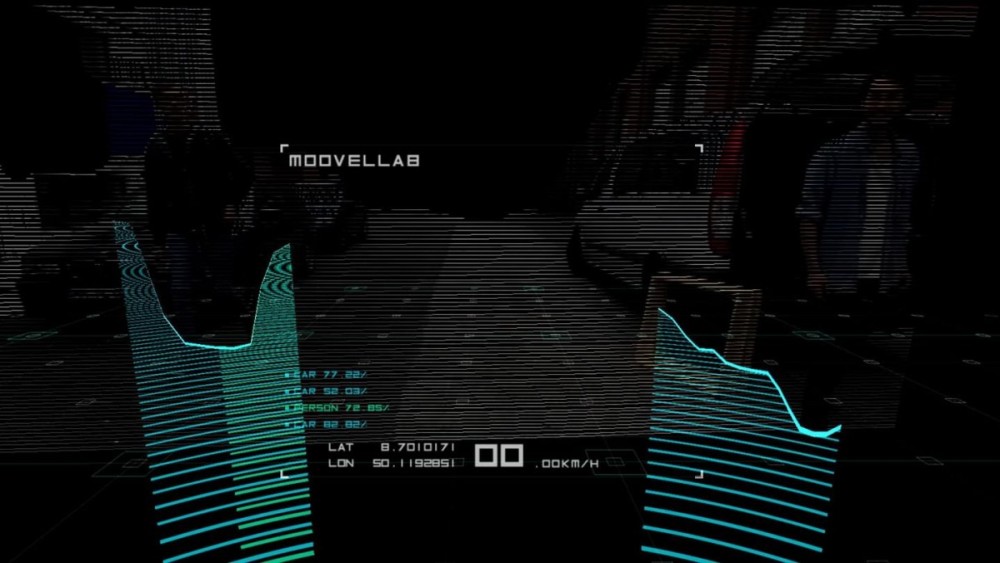

Aus binärem Code wird ein 3D-Bild

Das Auto vor mir und Reimann werfen einen türkisenen Schatten. Darunter steht ein Schriftzug: Person 70 %, Car 50 %. Eine Art Laserradar tastet die Entfernungen der Hindernisse vor mir ab. Die Kameras scannen mein Sichtfeld und die Software erkennt bestimmte Figuren. Wenn ich den Kopf drehe, verändern sich die Zahlen. Grob gilt: Je zentraler die Dinge im Sichtfeld sind, desto besser erkennt sie das Programm, desto höher der Prozentwert.

„Eigentlich sieht ein Auto nur Einsen und Nullen“, sagt Reimann, Werte, die die Sensoren erfassen und als binären Code weitergeben. Dass der Computer des Wagens die Werte in ein 3D-Bild zurückgerechnet, ist nur ein Zugeständnis an uns Menschen, die wir keine Codemassen innerhalb von Sekunden verarbeiten können.

Blick durch die VR-Brille – so ordnet die Software die Welt.

Meine Hände tasten das Lenkrad ab. Mit der rechten umfasse ich die Bremse, die ähnlich wie einem Fahrradlenker angebracht ist. Der linke Zeigefinger liegt auf dem Gashebel.

Vorsichtig rolle ich los. Ich weiß, dass Reimann neben mir läuft und einen Stop-Knopf trägt. Kaputtmachen kann ich also kaum etwas. Nach ein paar Metern habe ich mich an die Mischung aus Virtualität und Realität gewöhnt, die sogenannte Mixed Reality. Ich werde etwas wagemutiger und beschleunige auf ein parkendes Auto zu, die Elektromotoren surren. Der Wagen fährt zwar nur etwas schneller als Schrittgeschwindigkeit, weil Reimann ihn für unerfahrene Testfahrer wie mich gedrosselt hat. Doch in Bauchlage wirkt auch das bedrohlich. Ich bremse ab und weiche dem Auto aus.

Längst taste ich mich nicht mehr nur vorwärts, sondern rolle in einer großen Kurve über den Hinterhof. Zwischendurch frage ich mich, warum das Projekt auf einer Ausstellung nach der anderen zu sehen ist und mit Preisen ausgezeichnet wird. So spektakulär ist die Erfahrung auch wieder nicht.

Plötzlich: ein weißes Nichts

Dann erreiche ich in einen sonnendurchfluteten Teil des Hofes und auf einmal löst sich die Welt um mich herum auf: kein Horizont und keine Dinge, an denen ich mich orientieren könnte, nur ein weißes Nichts. So sehr ich meinen Kopf drehe, kann ich nichts erkennen. Und doch fühle ich, dass ich mich bewege: Mein Gleichgewichtssinn meldet, dass ich weiter meine Linkskurve fahre, und ich spüre kleine Erschütterungen. Mir wird flau im Magen, als ich durch dieses Nichts gleite.

Was, wenn nicht ich das Auto teste, sondern das Auto mich? Vielleicht sammelt es Daten über mein Fahrverhalten, damit es in der Zukunft „menschlicher“ entscheiden kann, wenn es denn irgendwann einmal alleine fährt und alle Sensoren ausfallen. Vollbremsung und einen Auffahrunfall riskieren? Oder ausrollen lassen und unkontrolliert in eine Menschenmenge oder Brückenpfeiler rauschen? Welche Variante ist für den Insassen sicherer, welche für andere Verkehrsteilnehmer? Ich habe mich intuitiv für die zweite Möglichkeit entschieden und bin nur vom Gas gegangen – warum, weiß ich nicht.

Ich frage mich, welche anderen „menschlichen“ Reaktionen für ein selbstfahrendes Auto interessant sein könnten. Vielleicht eine Situation, in der ich in Sekundenbruchteilen entscheiden muss: Rase ich in vier 40-Prozent-Fußgänger oder in zwei 80-Prozent-Radfahrer, weil ich nicht mehr bremsen kann?

Dann höre ich von oben eine Stimme: „Die Sonnenstrahlung stört manchmal den Infrarot-Sensor. Ich gebe dir Schatten, dann müsste es wieder gehen.“ Reimann tritt in das Weiß und meine Umgebung flackert wieder auf: die geparkten Autos und Motorräder, die Wand, der Wein und der Forscher selbst.

Wenig später komme ich am Startpunkt meiner Testfahrt an und setze die VR-Brille ab. Noch immer ist mir etwas schummrig. Der Gedanke, dass ich getestet wurde, lässt mich nicht los. Im Nachhinein bin ich unsicher, ob ich möchte, dass selbstfahrende Autos zukünftig weiterrollen, wenn ihre Sensoren ausfallen. Unsicher, ob ich möchte, dass mein Handeln zum Gesetz für autonomes Fahrzeuge wird.

Nachdenken über Grundfragen des autonomen Fahrens

Wahrscheinlich ist die Stärke des Projekts, dass es solche Gedanken auslöst – auch wenn der entscheidende Moment nicht geplant war: die Störung der Sensoren. In diesem Moment habe ich mich in das Auto hineingefühlt und über Grundfragen des autonomen Fahrens nachgedacht und erfahren, wie wenig nachvollziehbar meine eigenen Handlungen sind.

Ich wende mich an eine Kollegin von Reimann und frage leise, ob die Forscher meine Fahrt mitgeschnitten haben. Sie sagt: „Nein. Aber wir könnten das ganz einfach aufzeichnen“, sagt sie, „über ein HDMI-Kabel an der VR-Brille.“